先日、iOS11のベータ版を普段使いのiPhone6s Plusに入れた。

ARKitという新機能を使ったアプリを開発できるか、試してみるつもりで入れたが

ベータ版をメインのiPhoneに入れるのは結構覚悟が必要だった、、、

結局のところ、いつも使っているアプリはほぼ問題ない感じで動いているので

特に不便は感じていない。

あ、ひとつだけ、あったかな。ここに書くほどでもないレベルで。

さてARKit、かなり期待して試してみたが、、、どうなんでしょう?

いずれにしてもCGのデータが結構必要になるから、個人レベルのアプリでは苦しいかもしれない。

なにかUIに関してARで表示という使い方ならありえる。

今より(今のところ、水平面しかiOSでは認識しない)改善されれば、もっと使いやすくなるだろう。

同時に発表されたCore MLという機械学習(Machine Learning)のフレームワークは興味深い。

大まかにいえば「AI」。

こっちも面白そうだと思い、テストしてみた。

実際、iPhoneのカメラに写ったものをどの程度正確に認識できるのか?

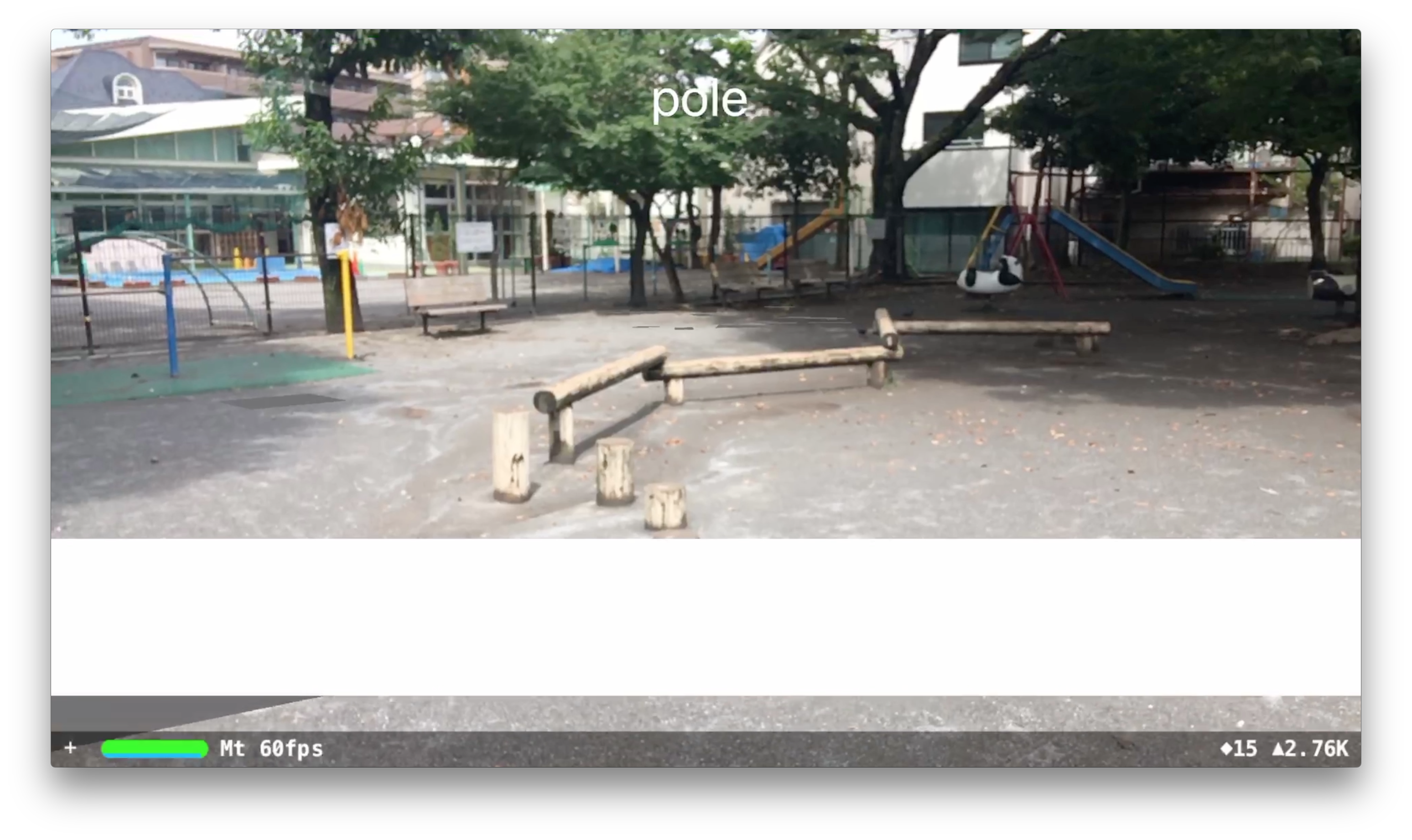

試しに作ったアプリのスクリーンレコーディングがこれ。

機械学習についてもう少し知識が無いと、画像認識に成功しているのか、していないのか?

その辺も判断することが難しい。

しかも公開されているオープンソースのデータは英語なので、それが合っているかどうかも一度日本語に訳さないといけない。

今後、自作アプリに活用できるのか、、、

8月も時間の許す限り、iOS11の新機能について研究したい。